Tarjeta gráfica

una placa o tarjeta gráfica, tarjeta de vídeo, tarjeta aceleradora de gráficos o adaptador de pantalla, es una tarjeta de expansión para una computadora, encargada de procesar los datos provenientes de la CPU y transformarlos en información comprensible y representable en un dispositivo de salida, como un monitor o televisor. Las tarjetas gráficas más comunes son las disponibles para las computadoras compatibles con la IBM PC, debido a la enorme popularidad de éstas, pero otras arquitecturas también hacen uso de este tipo de dispositivos.

Es habitual que se utilice el mismo término tanto a las habituales tarjetas dedicadas y separadas como a las GPU integradas en la placa base.

Algunas tarjetas gráficas han ofrecido funcionalidades añadidas como captura de vídeo, sintonización de TV, decodificación MPEG-2[1] y MPEG-4 o incluso conectores Firewire, de ratón, lápiz óptico o joystick.

Las tarjetas gráficas no son dominio exclusivo de los PC; contaron o cuentan con ellas dispositivos como los Commodore Amiga (conectadas mediante las ranuras Zorro II y Zorro III), Apple II, Apple Macintosh, Spectravideo SVI-328, equipos MSX y, por supuesto, en las videoconsolas modernas, como la Wii, la Playstation 3 y la Xbox360

La GPU

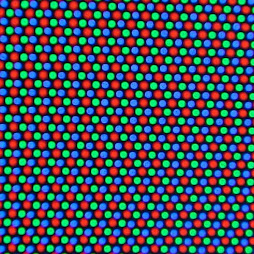

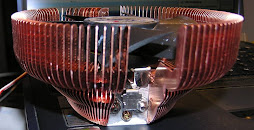

La GPU, —acrónimo de «graphics processing unit», que significa «unidad de procesamiento gráfico»— es un procesador (como la CPU) dedicado al procesamiento de gráficos; su razón de ser es aligerar la carga de trabajo del procesador central y, por ello, está optimizada para el cálculo en coma flotante, predominante en las funciones 3D. La mayor parte de la información ofrecida en la especificación de una tarjeta gráfica se refiere a las características de la GPU, pues constituye la parte más importante de la tarjeta. Dos de las más importantes de dichas características son la frecuencia de reloj del núcleo, que en 2006 oscilaba entre 250 MHz en las tarjetas de gama baja y 750 MHz en las de gama alta, y el número de pipelines (vertex y fragment shaders), encargadas de traducir una imagen 3D compuesta por vértices y líneas en una imagen 2D compuesta por píxeles.

Según la tarjeta gráfica esté integrada en la placa base (bajas prestaciones) o no, utilizará la memoria RAM propia del ordenador o dispondrá de una propia. Dicha memoria es la memoria de vídeo o VRAM. Su tamaño oscila entre 128 MB y 1 GB. La memoria empleada en 2006 estaba basada en tecnología DDR, destacando DDR2, GDDR3,GDDR4 y GDDR5. La frecuencia de reloj de la memoria se encontraba entre 400 MHz y 3,6 GHz.

Han conseguido hacer memorias GDDR5 a 7GHZ, gracias al proceso de reducción de 50 nm, permitiendo un gran ancho de banda en buses muy pequeños (incluso de 64 bits)

Una parte importante de la memoria de un adaptador de vídeo es el Z-Buffer, encargado de gestionar las coordenadas de profundidad de las imágenes en los gráficos 3D.

El RAMDAC

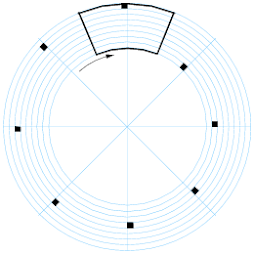

El RAMDAC es un conversor de [señal digitaldigital]] a analógico de memoria RAM. Se encarga de transformar las señales digitales producidas en el ordenador en una señal analógica que sea interpretable por el monitor. Según el número de bits que maneje a la vez y la velocidad con que lo haga, el conversor será capaz de dar soporte a diferentes velocidades de refresco del monitor (se recomienda trabajar a partir de 75 Hz, nunca con menos de 60).[9] Dada la creciente popularidad de los monitores digitales el RAMDAC está quedando obsoleto, puesto que no es necesaria la conversión analógica si bien es cierto que muchos conservan conexión VGA por compatibilida

Salidas SVGA, S-Video y DVI de una tarjeta gráfica

Los sistemas de conexión más habituales entre la tarjeta gráfica y el dispositivo visualizador (como un monitor o un televisor) son:

DA-15 conector RGB usado mayoritariamente en los Apple Macintosh

Digital TTL DE-9 : usado por las primitivas tarjetas de IBM (MDA, CGA y variantes, EGA y muy contadas VGA)

SVGA: estándar analógico de los años 1990; diseñado para dispositivos CRT, sufre de ruido eléctrico y distorsión por la conversión de digital a analógico y el error de muestreo al evaluar los píxeles a enviar al monitor.

DVI: sustituto del anterior, fue diseñado para obtener la máxima calidad de visualización en las pantallas digitales como los LCD o proyectores. Evita la distorsión y el ruido al corresponder directamente un píxel a representar con uno del monitor en la resolución nativa del mismo.

S-Video: incluido para dar soporte a televisores, reproductores de DVD, vídeos, y videoconsolas.

Otras no tan extendidas en 2007 son:

S-Video implementado sobre todo en tarjetas con sintonizador TV y/o chips con soporte de video NTSC/PAL

Vídeo Compuesto: analógico de muy baja resolución mediante conector RCA.

Vídeo por componentes: utilizado también para proyectores; de calidad comparable a la de SVGA, dispone de tres clavijas (Y, Cb y Cr).

HDMI: tecnología de audio y vídeo digital cifrado sin compresión en un mismo cable.

Extended Industry Standard Architecture

EISA.

El Extended Industry Standard Architecture (en inglés, Arquitectura Estándar Industrial Extendida), casi siempre abreviado EISA, es una arquitectura de bus para computadoras compatibles con el IBM PC. Fue anunciado a finales de 1988 y desarrollado por el llamado "Grupo de los Nueve" (AST, Compaq, Epson, Hewlett-Packard, NEC Corporation, Olivetti, Tandy, Wyse y Zenith Data Systems), vendedores de computadores clónicos como respuesta al uso por parte de IBM de su arquitectura propietaria MicroChannel (MCA) en su serie PS/2. Tuvo un uso limitado en computadores personales 386 y 486 hasta mediados de los años 1990, cuando fue reemplazado por los buses locales tales como el bus local VESA y el PCI

EISA amplía la arquitectura de bus ISA a 32 bits y permite que más de una CPU comparta el bus. El soporte de bus mastering también se mejora para permitir acceso hasta a 4 GB de memoria. A diferencia de MCA, EISA es compatible de forma descendente con ISA, por lo que puede aceptar tarjetas antiguas XT e ISA, siendo conexiones y las ranuras una ampliación de las del bus ISA.

A pesar de ser en cierto modo inferior a MCA, el estándar EISA fue muy favorecido por los fabricantes debido a la naturaleza propietaria de MCA, e incluso IBM fabricó algunas máquinas que lo soportaban. Pero en el momento en el que hubo una fuerte demanda de un bus de estas velocidades y prestaciones, el bus local VESA y posteriormente el PCI llenaron este nicho y el EISA desapareció en la oscuridad.

EISA introduce las siguientes mejoras sobre ISA:

Direcciones de memoria de 32 bits para CPU, DMA, y dispositivos de bus master.

Protocolo de transmisión síncrona para transferencias de alta velocidad.

Traducción automática de ciclos de bus entre maestros y esclavos EISA e ISA.

Soporte de controladores de periféricos maestros inteligentes.

33 MB/s de velocidad de transferencia para buses maestros y dispositivos DMA

Interrupciones compartidas .

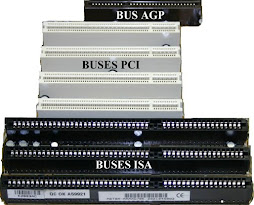

ISA

Se creó como un sistema de 8 bits en el IBM PC en 1980, y se extendió en 1983 como el XT bus architecture. El nuevo estándar de 16 bits se introduce en 1984 y se le llama habitualmente AT bus architecture. Diseñado para conectar tarjetas de ampliación a la placa madre, el protocolo también permite el bus mastering aunque sólo los primeros 16 MiB de la memoria principal están disponibles para acceso directo. El bus de 8 bits funciona a 4,77 MHz (la misma velocidad que el procesador Intel 8088 empleado en el IBM PC), mientras que el de 16 bits opera a 8 MHz (el de Intel 80286 del IBM AT). Está también disponible en algunas máquinas que no son compatibles IBM PC, como el AT&T Hobbit (de corta historia), los Commodore Amiga 2000 y los BeBox basados en PowerPC. Físicamente, el slot XT es un conector de borde de tarjeta de 62 contactos (31 por cara) y 8,5 centímetros, mientras que el AT se añade un segundo conector de 36 contactos (18 por cara), con un tamaño de 14 cm. Ambos suelen ser en color negro. Al ser retro compatibles, puede conectarse una tarjeta XT en un slot AT sin problemas, excepto en placas mal diseñadas.

En 1987, IBM comienza a reemplazar el bus ISA por su bus propietario MCA (Micro Channel Architecture) en un intento por recuperar el control de la arquitectura PC y con ello del mercado PC. El sistema es mucho más avanzado que ISA, pero incompatible física y lógicamente, por lo que los fabricantes de ordenadores responden con el Extended Industry Standard Architecture (EISA) y posteriormente con el VESA Local Bus (VLB). De hecho, VLB usa algunas partes originalmente diseñados para MCA debido a que los fabricantes de componentes ya tienen la habilidad de fabricarlos. Ambos son extensiones compatibles con el estándar ISA.

Los usuarios de máquinas basadas en ISA tenían que disponer de información especial sobre el hardware que iban a añadir al sistema. Aunque un puñado de tarjetas eran esencialmente Plug-and-play (enchufar y listo), no era lo habitual. Frecuentemente había que configurar varias cosas al añadir un nuevo dispositivo, como la IRQ, las direcciones de entrada/salida, o el canal DMA. MCA había resuelto esos problemas, y actualmente PCI incorpora muchas de las ideas que nacieron con MCA (aunque descienden más directamente de EISA).

Estos problema con la configuración llevaron a la creación de ISA PnP, un sistema Plug-and-play que usa una combinación de modificaciones al hardware, la BIOS del sistema, y el software del sistema operativo que automáticamente maneja los detalles más gruesos. En realidad, ISA PnP acabó convirtiéndose en un dolor de cabeza crónico, y nunca fue bien soportado excepto al final de la historia de ISA. De ahí proviene la extensión de la frase sarcástica "plug-and-pray" (enchufar y rezar).

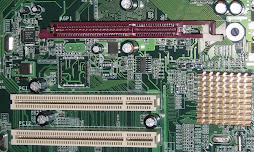

Los slots PCI fueron el primer puerto de expansión físicamente incompatible con ISA que lograron expulsarla de la placa madre. Al principio, las placas base eran en gran parte ISA, incluyendo algunas ranuras del PCI. Pero a mitad de los 90, los dos tipos de slots estaban equilibrados, y al poco los ISA pasaron a ser minoría en los ordenadores de consumo. Las especificaciones PC 97 de Microsoft recomendaban que los slots ISA se retiraran por completo, aunque la arquitectura del sistema todavía requiera de ISA en modo residual para direccionar las lectoras de disquete, los puertos RS-232, etc. Los slots ISA permanecen por algunos años más y es posible ver placas con un slot Accelerated Graphics Port (AGP) justo al lado de la CPU, una serie de slots PCI, y uno o dos slots ISA cerca del borde.

Es también notable que los slots PCI están "rotados" en comparación con los ISA. Los conectores externos y la circuitería principal de ISA están dispuestos en el lado izquierdo de la placa, mientras que los de PCI lo están en el lado derecho, siempre mirando desde arriba. De este modo ambos slots podían estar juntos, pudiendo usarse sólo uno de ellos, lo que exprimía la placa madre.

El ancho de banda máximo del bus ISA de 16 bits es de 16 Mbyte/segundo. Este ancho de banda es insuficiente para las necesidades actuales, tales como tarjetas de vídeo de alta resolución, por lo que el bus ISA no se emplea en los PC modernos (2004), en los que ha sido sustituido por el bus PCI.

La arquitectura XT es una arquitectura de bus de 8 bits usada en los PC con procesadores Intel 8086 y 8088, como los IBM PC e IBM PC XT en los 80. Precede al la arquitectura AT de 16 bits usada en las máquinas compatibles IBM Personal Computer/AT.

El bus XT tiene cuatro canales DMA, de los que tres están en los slots de expansión. De esos tres, dos están normalmente asignados a funciones de la máquina:

VESA: Con el fin de desarrollar pantallas y tarjetas con una resolución superior a la ofrecida por VGA, en el año 1989 nace VESA ( Video Electronics Standards Association o Asociación para estándares electrónicos y de video) a finales de los años 80. Este tipo de tarjetas (y puertos) permite una mayor velocidad que el puerto ISA, siendo utilizado como puerto de alta velocidad para gráficas hasta la aparición de los puertos PCI. Con un bus de 32 bits, una frecuencia de 33 Mhz y un ancho de banda de 160 Mb/s permite resoluciones de 800x600, ampliando notablemente la cantidad de colores a mostrar (se abandona el sistema de paleta y se empieza a definir el sistema de profundidad de color, que permite millones de colores). Uno de los mayores inconvenientes de este sistema era el tamaño de las tarjetas, que superaban los 30cm de longitud. Peripheral Component Interconnect

Un Peripheral Component Interconnect (PCI, "Interconexión de Componentes Periféricos") consiste en un bus de ordenador estándar para conectar dispositivos periféricos directamente a su placa base. Estos dispositivos pueden ser circuitos integrados ajustados en ésta (los llamados "dispositivos planares" en la especificación PCI) o tarjetas de expansión que se ajustan en conectores. Es común en PC, donde ha desplazado al ISA como bus estándar, pero también se emplea en otro tipo de ordenadores.

A diferencia de los buses ISA, el bus PCI permite configuración dinámica de un dispositivo periférico. En el tiempo de arranque del sistema, las tarjetas PCI y el BIOS interactúan y negocian los recursos solicitados por la tarjeta PCI. Esto permite asignación de IRQs y direcciones del puerto por medio de un proceso dinámico diferente del bus ISA, donde las IRQs tienen que ser configuradas manualmente usando jumpers externos. Las últimas revisiones de ISA y el bus MCA de IBM ya incorporaron tecnologías que automatizaban todo el proceso de configuración de las tarjetas, pero el bus PCI demostró una mayor eficacia en tecnología "plug and play". Aparte de esto, el bus PCI proporciona una descripción detallada de todos los dispositivos PCI conectados a través del espacio de configuración PCI.

La especificación PCI cubre el tamaño físico del bus, características eléctricas, cronómetro del bus y sus protocolos. El grupo de interés especial de PCI (PCI Special Interest Group)

Accelerated Graphics Port

AGP

Accelerated Graphics Port (AGP, Puerto de Gráficos Acelerado, en ocasiones llamado Advanced Graphics Port, Puerto de Gráficos Avanzado) es un puerto (puesto que sólo se puede conectar un dispositivo, mientras que en el bus se pueden conectar varios) desarrollado por Intel en 1996 como solución a los cuellos de botella que se producían en las tarjetas gráficas que usaban el bus PCI. El diseño parte de las especificaciones del PCI 2.1.

El puerto AGP es de 32 bit como PCI pero cuenta con notables diferencias como 8 canales más adicionales para acceso a la memoria RAM. Además puede acceder directamente a esta a través del puente norte pudiendo emular así memoria de vídeo en la RAM. La velocidad del bus es de 66 MHz.

El bus AGP cuenta con diferentes modos de funcionamiento.

AGP 1X: velocidad 66 MHz con una tasa de transferencia de 266 MB/s y funcionando a un voltaje de 3,3V.

AGP 2X: velocidad 133 MHz con una tasa de transferencia de 532 MB/s y funcionando a un voltaje de 3,3V.

AGP 4X: velocidad 266 MHz con una tasa de transferencia de 1 GB/s y funcionando a un voltaje de 3,3 o 1,5V para adaptarse a los diseños de las tarjetas gráficas.

AGP 8X: velocidad 533 MHz con una tasa de transferencia de 2 GB/s y funcionando a un voltaje de 0,7V o 1,5V.

Estas tasas de transferencias se consiguen aprovechando los ciclos de reloj del bus mediante un multiplicador pero sin modificarlos físicamente..

El puerto AGP se utiliza exclusivamente para conectar tarjetas gráficas, y debido a su arquitectura sólo puede haber una ranura. Dicha ranura mide unos 8 cm y se encuentra a un lado de las ranuras PCI.

A partir de 2006, el uso del puerto AGP ha ido disminuyendo con la aparición de una nueva evolución conocida como PCI-Express, que proporciona mayores prestaciones en cuanto a frecuencia y ancho de banda. Así, los principales fabricantes de tarjetas gráficas, como ATI y nVIDIA, han ido presentando cada vez menos productos para este puerto.

PCI-Express

PCI Express (anteriormente conocido por las siglas 3GIO, en el caso de las "Entradas/Salidas de Tercera Generación", en inglés: 3rd Generation I/O) es un nuevo desarrollo del bus PCI que usa los conceptos de programación y los estándares de comunicación existentes, pero se basa en un sistema de comunicación serie mucho más rápido. Este sistema es apoyado principalmente por Intel, que empezó a desarrollar el estándar con nombre de proyecto Arapahoe después de retirarse del sistema Infiniband.

PCI Express es abreviado como PCI-E o PCIe, aunque erróneamente se le suele abreviar como PCI-X o PCIx. Sin embargo, PCI Express no tiene nada que ver con PCI-X que es una evolución de PCI, en la que se consigue aumentar el ancho de banda mediante el incremento de la frecuencia, llegando a ser 32 veces más rápido que el PCI 2.1. Su velocidad es mayor que PCI-Express, pero presenta el inconveniente de que al instalar más de un dispositivo la frecuencia base se reduce y pierde velocidad de transmisión.

lunes, 26 de octubre de 2009

martes, 20 de octubre de 2009

EL SONIDO

Sonido

El sonido, en física, es cualquier fenómeno que involucre la propagación en forma de ondas elásticas (sean audibles o no), generalmente a través de un fluido (u otro medio elástico) que este generando el movimiento vibratorio de un cuerpo.

El sonido humanamente audible consiste en ondas sonoras consistentes en oscilaciones de la presión del aire, que son convertidas en ondas mecánicas en el oído humano y percibidas por el cerebro. La propagación del sonido es similar en los fluidos, donde el sonido toma la forma de fluctuaciones de presión. En los cuerpos sólidos la propagación del sonido involucra variaciones del estado tensional del medio.

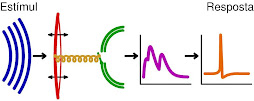

Representación esquemática del oido. (Azul: ondas sonoras. Rojo: tímpano. Amarillo: Cóclea. Verde: células de receptores auditivos. Purpura: espectro de frecuencia de respuesta de lo oído. Naranja: impulso del nervio.)

La propagación del sonido involucra transporte de energía sin transporte de materia, en forma de ondas mecánicas que se propagan a través de la materia sólida, líquida o gaseosa. Como las vibraciones se producen en la misma dirección en la que se propaga el sonido, se trata de una onda longitudinal.

Física del sonido

La física del sonido es estudiada por la acústica, que trata tanto de la propagación de las ondas sonoras en los diferentes tipos de medios continuos como la interacción de estas ondas sonoras con los cuerpos físicos.

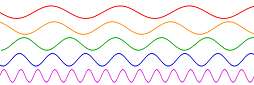

onda sinusoidal; Variación de frecuencia; Abajo podemos ver las frecuencias más altas. El eje horizontal representa el tiempo.

Propagación del sonido

Ciertas características de los fluidos y de los sólidos influyen en la onda de sonido. Es por eso que el sonido se propaga en los sólidos y en los líquidos con mayor rapidez que en los gases. En general cuanto mayor sea la compresibilidad (1/K) del medio tanto menor es la velocidad del sonido. También la densidad es un factor importante en la velocidad de propagación, en general a mayor sea la densidad (ρ), a igualdad de todo lo demás, tanto menor es la velocidad de la propagación del sonido. La velocidad del sonido se relaciona con esas magnitudes mediante:

En los gases, la temperatura influye tanto la compresibilidad como la densidad, de tal manera que el factor de importancia suele ser la temperatura misma.

Para que el sonido se transmita se necesita que las moléculas vibren en torno a sus posiciones de equilibrio.

En algunas zonas de las moléculas de aire, al vibrar se juntan (zonas de compresion)y en otras zonas se alejan (zonas de rarefaccion),esta alteracion de las moléculas de aire es lo que produce el sonido.

Magnitudes físicas del sonido

Como todo movimiento ondulatorio, el sonido puede representarse como una suma de curvas sinusoides con un factor de amplitud, que se pueden caracterizar por las mismas magnitudes y unidades de medida que a cualquier onda de frecuencia bien definida: Longitud de onda (λ), frecuencia (f) o inversa del período (T), amplitud que indica la cantidad de energía que contiene una señal sonora) y no hay que confundir amplitud con volumen o potencia acústica. Y finalmente cuando se considera la superposición de diferentes ondas es importante la fase que representa el retardo relativo en la posición de una onda con respecto a otra.

Sin embargo, un sonido complejo cualquiera no está caracterizado por los parámetros anteriores, ya que en general un sonido cualquiera es una combinación de ondas sonoras que difieren en los cinco parámetros anteriores. La caracterización de un sonido arbitrariamente complejo implica analizar tanto la energía transmitida como la distribución de dicha energía entre las diversas ondas componentes, para ello resulta útil investigar:

Potencia acústica: El nivel de potencia acústica es la cantidad de energía radiada en forma de ondas por unidad de tiempo por una fuente determinada. La potencia acústica depende de la amplitud.

Espectro de frecuencias: que permite conocer en qué frecuencias se transmite la mayor parte de la energía.

Velocidad del sonido

El sonido tiene una velocidad de 331,5 m/s cuando: la temperatura es de 0 °C, la presión atmosférica es de 1 atm (nivel del mar) y se presenta una humedad relativa del aire de 0 % (aire seco). Aunque depende muy poco de la presión del aire.

La velocidad del sonido depende del tipo de material. Cuando el sonido se desplaza en los sólidos tiene mayor velocidad que en los líquidos, y en los líquidos es más veloz que en los gases. Esto se debe a que las partículas en los sólidos están más cercanas.

U.S. Navy F/A-18 Avión rompiendo la barrera del sonido.

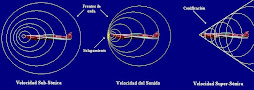

Comportamiento de las ondas de sonido a diferentes velocidades

La velocidad del sonido se puede calcular en relación a la temperatura de la siguiente manera:

Donde:

, es la temperatura en grados Celsius.

Si la temperatura ambiente es de 15 °C, la velocidad de propagación del sonido es 340 m/s (1224 km/h ). Este valor corresponde a 1 MACH.

Reverberación

La reverberación es la suma total de las reflexiones del sonido que llegan al lugar del oyente en diferentes momentos del tiempo. Auditivamente se caracteriza por una prolongación, a modo de "colasonora", que se añade al sonido original. La duración y la coloración tímbrica de esta cola dependen de: La distancia entre el oyente y la fuente sonora; la naturaleza de las superficies que reflejan el sonido. En situaciones naturales hablamos de sonido directo para referirnos al sonido que se transmite directamente desde la fuente sonora hasta nosotros (o hasta el mecanismo de captación que tengamos). Por otra parte, el sonido reflejado es el que percibimos después de que haya rebotado en las superficies que delimitan el recinto acústico, o en los objetos que se encuentren en su trayectoria. Evidentemente, la trayectoria del sonido reflejado siempre será más larga que la del sonido directo, de manera que -temporalmente- escuchamos primero el sonido seco, y unos instantes más tarde escucharemos las primeras reflexiones (early reflections); a medida que transcurre el tiempo las reflexiones que nos llegan son cada vez de menor intensidad, hasta que desparecen. Nuestra sensación, no obstante, no es la de escuchar sonidos separados, ya que el cerebro los integra en un único precepto, siempre que las reflexiones lleguen con una separación menor de unos 50 milisegundos. Esto es lo que se denomina efecto Haas o efecto de precedencia.ariel12

Fisiología del sonido

El aparato auditivo

Los sonidos son percibidos a través del aparato auditivo que recibe las ondas sonoras, que son convertidas en movimientos de los osteocillos óticos y percibidas en el oído interno que a su vez las transmite mediante el sistema nervioso al cerebro. Esta habilidad se tiene incluso antes de nacer[cita requerida].

La voz humana

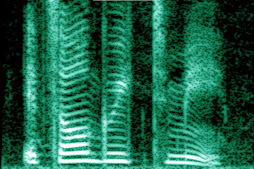

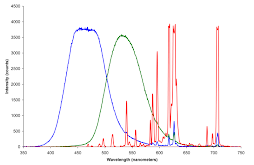

La espectrografía de la voz humana revela su rico contenido armónico.

La voz humana se produce por la vibración de las cuerdas vocales, lo cual genera una onda sonora que es combinación de varias frecuencias y sus correspondientes armónicos. La cavidad buco-nasal sirve para crear ondas cuasiestacionarias por lo que ciertas frecuencias denominadas formantes. Cada segmento de sonido del habla viene caracterizado por un cierto espectro de frecuencias o distribución de la energía sonora en las diferentes frecuencias. El oído humano es capaz de identificar diferentes formantes de dicho sonido y percibir cada sonido con formantes diferentes como cualitativamente diferentes, eso es lo que permite por ejemplo distinguir dos vocales. Típicamente el primer formante, el de frecuencia más baja está relacionada con la abertura de la vocal que en última instancia está relacionada con la frecuencia de las ondas estacionarias que vibran verticalmente en la cavidad. El segundo formante está relacionado con la vibración el la dirección horizontal y está relacionado con si la vocal es anterior, central o posterior.

La voz masculina tiene un tono fundamental de entre 100 y 200 Hz, mientras que la voz femenina es más aguda, típicamente está entre 150 y 300 Hz. Las voces infantiles son aún más agudas. Sin el filtrado por resonancia que produce la cavidad buco nasal nuestras emisiones sonoras no tendrían la claridad necesaria para ser audibles. Ese proceso de filtrado es precisamente lo que permite generar los diversos formantes de cada unidad segmental del habla.

Sonidos del habla

Las lenguas humanas usan segmentos homogéneos reconocibles de unas decenas de milisegundos de duración, que componen los sonidos del habla, técnicamente llamados fonos. Lingüísticamente no todas las diferencias acústicas son relevantes, por ejemplo las mujeres y los niños tienen en general tonos más agudos, por lo que todos los sonidos que producen tienen en promedio una frecuencia fundamental y unos armónicos más altos.

Los hablantes competentes de una lengua aprenden a "clasificar" diferentes sonidos cualitativamente similares en clases de equivalencia de rasgos relevantes. Esas clases de equivalencia reconocidas por los hablantes son los constructos mentales que llamamos fonemas. La mayoría de lenguas naturales tiene unas pocas decenas de fonemas distintivos, a pesar de que las variaciones acústicas de los fonos y sonidos son enormes.

Resonancia

Es el fenómeno que se produce cuando los cuerpos vibran con la misma frecuencia, uno de los cuales se puso a vibrar al recibir las frecuencias del otro. Para entender el fenómeno de la resonancia existe un ejemplo muy sencillo, Supóngase que se tiene un tubo con agua y muy cerca de él (sin éstos en contacto) tenemos un diapasón, si golpeamos el diapasón con un metal, mientras echan agua en el tubo, cuando el agua alcance determinada altura el sonido será mas fuerte; esto se debe a que la columna de agua contenida en el tubo se pone a vibrar con la misma frecuencia que la que tiene el diapasón, lo que evidencia por qué las frecuencias se refuerzan y en consecuencia aumenta la intensidad del sonido. Un ejemplo podria ser el efecto de afinar las cuerdas de la guitarra, puesto que al afinar, lo que se hace es igualar las frecuencias, es decir poner en resnancia el sonido de las cuerdas.

El sonido en la música

El sonido, en combinación con el silencio, es la materia prima de la música. En música los sonidos se califican en categorías como: largos y cortos, fuertes y débiles, agudos y graves, agradables y desagradables. El sonido ha estado siempre presente en la vida cotidiana del hombre. A lo largo de la historia el ser humano ha inventado una serie de reglas para ordenarlo hasta construir algún tipo de lenguaje musical.

Propiedades

Altura: Indica si el sonido es grave o agudo, que depende de la frecuencia:

vibración lenta = baja frecuencia = sonido grave

vibración rápida = alta frecuencia = sonido agudo.

Duración: es el tiempo durante el cual se mantiene dicho sonido. Los únicos instrumentos acústicos que pueden mantener los sonidos el tiempo que quieran, son los de cuerda con arco como el violín por ejemplo, y los de viento (utilizando la respiración circular ó continua); pero por lo general, los de viento dependen de la capacidad pulmonar, y los de cuerda según el cambio del arco producido por el ejecutante.

Timbre o color : la voz propia de cada instrumento que distingue entre los sonidos y los ruidos

Intensidad o fuerza o potencia : lo fuerte o suave de un sonido :

1. fortissimo o muy fuerte 2. forte o fuerte 3. mezzoforte o medio fuerte 4. mezzopiano o medio suave 5. piano o suave 6. pianísimo o muy suave

Características o cualidades del sonido

Las cuatro cualidades básicas del sonido son:

La altura: viene determinada por la frecuencia fundamental de las ondas sonoras (es lo que permite distinguir entre sonidos graves, agudos o medios) medida en ciclos por segundo o hercios (Hz).

Para que los humanos podamos percibir un sonido, éste debe estar comprendido entre el rango de audición de 20 y 20.000 Hz. Por debajo de este rango tenemos los infrasonidos y por encima los ultrasonidos. A esto se le denomina rango de frecuencia audible. Cuanta más edad se tiene, este rango va reduciéndose tanto en graves como en agudos.

Véase también: Tono y altura (música)

La intensidad: es la cantidad de energía acústica que contiene un sonido. La intensidad viene determinada por la potencia, que a su vez está determinada por la amplitud y nos permite distinguir si el sonido es fuerte o débil.

Los sonidos que percibimos deben superar el umbral auditivo (0 dB) y no llegar al umbral de dolor (140 dB). Esta cualidad la medimos con el sonómetro y los resultados se expresan en decibelios (dB) en honor al científico e inventor Alexander Graham Bell.

En música se escriben así: ``piano pianissimo´´(ppp) mas suave que pianissimo, ``Pianissimo´´ (pp) Muy suave, ``Piano´´ (p) suave, ``Mezzo Piano´´ (mp) medio suave, ``Mezzo Forte´´ (mf) medio fuerte, ``Forte´´ (f) fuerte, ``Fortissimo´´ (ff) Muy fuerte, ``forte fortissimo´(fff) mas fuerte que fortissimo.

El timbre: es la cualidad que confiere al sonido los armónicos que acompañan a la frecuencia fundamental.

Esta cualidad es la que permite distinguir dos sonidos, por ejemplo, entre la misma nota (tono) con igual intensidad producida por dos instrumentos musicales distintos. Se define como la calidad del sonido. cada cuerpo sonoro vibra de una forma distinta. Las diferencias se dan no solamente por la naturaleza del cuerpo sonoro (madera, metal, piel tensada, etc), sino también por la manera de hacerlo sonar (golpear, frotar, rascar). Una misma nota suena distinta si la toca una flauta, un violín, una trompeta… cada instrumento tiene un timbre que lo identifica o lo diferencia de los demás. Con la voz sucede lo mismo. El sonido dado por un hombre, una mujer, un/a niño/a tienen distinto timbre. El timbre nos permitirá distinguir si la voz es áspera,dulce, ronca o aterciopelada. También influye en la variación del timbre la calidad del material que se utilice. Así pues, el sonido será claro, sordo, agradable o molesto.

La duración: es la cualidad que determina el tiempo de vibración de un objeto. Por ejemplo, podemos escuchar sonidos largos, cortos, muy cortos, etc. Es el tiempo durante el cual se mantiene un sonido, está determinada por la longitud, que indica el tamaño de una onda, que es la distancia entre el principio y el final de una onda completa (ciclo); según esto podemos decir que por duración los sonidos pueden ser largos o cortos.

CUALIDAD

CARACTERÍSTICA

RANGO

Altura

Frecuencia de onda

Agudo, medio, grave

Duración

Longitud de onda o tiempo de vibración

Largo o corto

Intensidad

Amplitud de onda

Fuerte, débil o suave

Timbre

Armónicos de onda o forma de la onda

Fuente emisora del sonido

El sonido, en física, es cualquier fenómeno que involucre la propagación en forma de ondas elásticas (sean audibles o no), generalmente a través de un fluido (u otro medio elástico) que este generando el movimiento vibratorio de un cuerpo.

El sonido humanamente audible consiste en ondas sonoras consistentes en oscilaciones de la presión del aire, que son convertidas en ondas mecánicas en el oído humano y percibidas por el cerebro. La propagación del sonido es similar en los fluidos, donde el sonido toma la forma de fluctuaciones de presión. En los cuerpos sólidos la propagación del sonido involucra variaciones del estado tensional del medio.

Representación esquemática del oido. (Azul: ondas sonoras. Rojo: tímpano. Amarillo: Cóclea. Verde: células de receptores auditivos. Purpura: espectro de frecuencia de respuesta de lo oído. Naranja: impulso del nervio.)

La propagación del sonido involucra transporte de energía sin transporte de materia, en forma de ondas mecánicas que se propagan a través de la materia sólida, líquida o gaseosa. Como las vibraciones se producen en la misma dirección en la que se propaga el sonido, se trata de una onda longitudinal.

Física del sonido

La física del sonido es estudiada por la acústica, que trata tanto de la propagación de las ondas sonoras en los diferentes tipos de medios continuos como la interacción de estas ondas sonoras con los cuerpos físicos.

onda sinusoidal; Variación de frecuencia; Abajo podemos ver las frecuencias más altas. El eje horizontal representa el tiempo.

Propagación del sonido

Ciertas características de los fluidos y de los sólidos influyen en la onda de sonido. Es por eso que el sonido se propaga en los sólidos y en los líquidos con mayor rapidez que en los gases. En general cuanto mayor sea la compresibilidad (1/K) del medio tanto menor es la velocidad del sonido. También la densidad es un factor importante en la velocidad de propagación, en general a mayor sea la densidad (ρ), a igualdad de todo lo demás, tanto menor es la velocidad de la propagación del sonido. La velocidad del sonido se relaciona con esas magnitudes mediante:

En los gases, la temperatura influye tanto la compresibilidad como la densidad, de tal manera que el factor de importancia suele ser la temperatura misma.

Para que el sonido se transmita se necesita que las moléculas vibren en torno a sus posiciones de equilibrio.

En algunas zonas de las moléculas de aire, al vibrar se juntan (zonas de compresion)y en otras zonas se alejan (zonas de rarefaccion),esta alteracion de las moléculas de aire es lo que produce el sonido.

Magnitudes físicas del sonido

Como todo movimiento ondulatorio, el sonido puede representarse como una suma de curvas sinusoides con un factor de amplitud, que se pueden caracterizar por las mismas magnitudes y unidades de medida que a cualquier onda de frecuencia bien definida: Longitud de onda (λ), frecuencia (f) o inversa del período (T), amplitud que indica la cantidad de energía que contiene una señal sonora) y no hay que confundir amplitud con volumen o potencia acústica. Y finalmente cuando se considera la superposición de diferentes ondas es importante la fase que representa el retardo relativo en la posición de una onda con respecto a otra.

Sin embargo, un sonido complejo cualquiera no está caracterizado por los parámetros anteriores, ya que en general un sonido cualquiera es una combinación de ondas sonoras que difieren en los cinco parámetros anteriores. La caracterización de un sonido arbitrariamente complejo implica analizar tanto la energía transmitida como la distribución de dicha energía entre las diversas ondas componentes, para ello resulta útil investigar:

Potencia acústica: El nivel de potencia acústica es la cantidad de energía radiada en forma de ondas por unidad de tiempo por una fuente determinada. La potencia acústica depende de la amplitud.

Espectro de frecuencias: que permite conocer en qué frecuencias se transmite la mayor parte de la energía.

Velocidad del sonido

El sonido tiene una velocidad de 331,5 m/s cuando: la temperatura es de 0 °C, la presión atmosférica es de 1 atm (nivel del mar) y se presenta una humedad relativa del aire de 0 % (aire seco). Aunque depende muy poco de la presión del aire.

La velocidad del sonido depende del tipo de material. Cuando el sonido se desplaza en los sólidos tiene mayor velocidad que en los líquidos, y en los líquidos es más veloz que en los gases. Esto se debe a que las partículas en los sólidos están más cercanas.

U.S. Navy F/A-18 Avión rompiendo la barrera del sonido.

Comportamiento de las ondas de sonido a diferentes velocidades

La velocidad del sonido se puede calcular en relación a la temperatura de la siguiente manera:

Donde:

, es la temperatura en grados Celsius.

Si la temperatura ambiente es de 15 °C, la velocidad de propagación del sonido es 340 m/s (1224 km/h ). Este valor corresponde a 1 MACH.

Reverberación

La reverberación es la suma total de las reflexiones del sonido que llegan al lugar del oyente en diferentes momentos del tiempo. Auditivamente se caracteriza por una prolongación, a modo de "colasonora", que se añade al sonido original. La duración y la coloración tímbrica de esta cola dependen de: La distancia entre el oyente y la fuente sonora; la naturaleza de las superficies que reflejan el sonido. En situaciones naturales hablamos de sonido directo para referirnos al sonido que se transmite directamente desde la fuente sonora hasta nosotros (o hasta el mecanismo de captación que tengamos). Por otra parte, el sonido reflejado es el que percibimos después de que haya rebotado en las superficies que delimitan el recinto acústico, o en los objetos que se encuentren en su trayectoria. Evidentemente, la trayectoria del sonido reflejado siempre será más larga que la del sonido directo, de manera que -temporalmente- escuchamos primero el sonido seco, y unos instantes más tarde escucharemos las primeras reflexiones (early reflections); a medida que transcurre el tiempo las reflexiones que nos llegan son cada vez de menor intensidad, hasta que desparecen. Nuestra sensación, no obstante, no es la de escuchar sonidos separados, ya que el cerebro los integra en un único precepto, siempre que las reflexiones lleguen con una separación menor de unos 50 milisegundos. Esto es lo que se denomina efecto Haas o efecto de precedencia.ariel12

Fisiología del sonido

El aparato auditivo

Los sonidos son percibidos a través del aparato auditivo que recibe las ondas sonoras, que son convertidas en movimientos de los osteocillos óticos y percibidas en el oído interno que a su vez las transmite mediante el sistema nervioso al cerebro. Esta habilidad se tiene incluso antes de nacer[cita requerida].

La voz humana

La espectrografía de la voz humana revela su rico contenido armónico.

La voz humana se produce por la vibración de las cuerdas vocales, lo cual genera una onda sonora que es combinación de varias frecuencias y sus correspondientes armónicos. La cavidad buco-nasal sirve para crear ondas cuasiestacionarias por lo que ciertas frecuencias denominadas formantes. Cada segmento de sonido del habla viene caracterizado por un cierto espectro de frecuencias o distribución de la energía sonora en las diferentes frecuencias. El oído humano es capaz de identificar diferentes formantes de dicho sonido y percibir cada sonido con formantes diferentes como cualitativamente diferentes, eso es lo que permite por ejemplo distinguir dos vocales. Típicamente el primer formante, el de frecuencia más baja está relacionada con la abertura de la vocal que en última instancia está relacionada con la frecuencia de las ondas estacionarias que vibran verticalmente en la cavidad. El segundo formante está relacionado con la vibración el la dirección horizontal y está relacionado con si la vocal es anterior, central o posterior.

La voz masculina tiene un tono fundamental de entre 100 y 200 Hz, mientras que la voz femenina es más aguda, típicamente está entre 150 y 300 Hz. Las voces infantiles son aún más agudas. Sin el filtrado por resonancia que produce la cavidad buco nasal nuestras emisiones sonoras no tendrían la claridad necesaria para ser audibles. Ese proceso de filtrado es precisamente lo que permite generar los diversos formantes de cada unidad segmental del habla.

Sonidos del habla

Las lenguas humanas usan segmentos homogéneos reconocibles de unas decenas de milisegundos de duración, que componen los sonidos del habla, técnicamente llamados fonos. Lingüísticamente no todas las diferencias acústicas son relevantes, por ejemplo las mujeres y los niños tienen en general tonos más agudos, por lo que todos los sonidos que producen tienen en promedio una frecuencia fundamental y unos armónicos más altos.

Los hablantes competentes de una lengua aprenden a "clasificar" diferentes sonidos cualitativamente similares en clases de equivalencia de rasgos relevantes. Esas clases de equivalencia reconocidas por los hablantes son los constructos mentales que llamamos fonemas. La mayoría de lenguas naturales tiene unas pocas decenas de fonemas distintivos, a pesar de que las variaciones acústicas de los fonos y sonidos son enormes.

Resonancia

Es el fenómeno que se produce cuando los cuerpos vibran con la misma frecuencia, uno de los cuales se puso a vibrar al recibir las frecuencias del otro. Para entender el fenómeno de la resonancia existe un ejemplo muy sencillo, Supóngase que se tiene un tubo con agua y muy cerca de él (sin éstos en contacto) tenemos un diapasón, si golpeamos el diapasón con un metal, mientras echan agua en el tubo, cuando el agua alcance determinada altura el sonido será mas fuerte; esto se debe a que la columna de agua contenida en el tubo se pone a vibrar con la misma frecuencia que la que tiene el diapasón, lo que evidencia por qué las frecuencias se refuerzan y en consecuencia aumenta la intensidad del sonido. Un ejemplo podria ser el efecto de afinar las cuerdas de la guitarra, puesto que al afinar, lo que se hace es igualar las frecuencias, es decir poner en resnancia el sonido de las cuerdas.

El sonido en la música

El sonido, en combinación con el silencio, es la materia prima de la música. En música los sonidos se califican en categorías como: largos y cortos, fuertes y débiles, agudos y graves, agradables y desagradables. El sonido ha estado siempre presente en la vida cotidiana del hombre. A lo largo de la historia el ser humano ha inventado una serie de reglas para ordenarlo hasta construir algún tipo de lenguaje musical.

Propiedades

Altura: Indica si el sonido es grave o agudo, que depende de la frecuencia:

vibración lenta = baja frecuencia = sonido grave

vibración rápida = alta frecuencia = sonido agudo.

Duración: es el tiempo durante el cual se mantiene dicho sonido. Los únicos instrumentos acústicos que pueden mantener los sonidos el tiempo que quieran, son los de cuerda con arco como el violín por ejemplo, y los de viento (utilizando la respiración circular ó continua); pero por lo general, los de viento dependen de la capacidad pulmonar, y los de cuerda según el cambio del arco producido por el ejecutante.

Timbre o color : la voz propia de cada instrumento que distingue entre los sonidos y los ruidos

Intensidad o fuerza o potencia : lo fuerte o suave de un sonido :

1. fortissimo o muy fuerte 2. forte o fuerte 3. mezzoforte o medio fuerte 4. mezzopiano o medio suave 5. piano o suave 6. pianísimo o muy suave

Características o cualidades del sonido

Las cuatro cualidades básicas del sonido son:

La altura: viene determinada por la frecuencia fundamental de las ondas sonoras (es lo que permite distinguir entre sonidos graves, agudos o medios) medida en ciclos por segundo o hercios (Hz).

Para que los humanos podamos percibir un sonido, éste debe estar comprendido entre el rango de audición de 20 y 20.000 Hz. Por debajo de este rango tenemos los infrasonidos y por encima los ultrasonidos. A esto se le denomina rango de frecuencia audible. Cuanta más edad se tiene, este rango va reduciéndose tanto en graves como en agudos.

Véase también: Tono y altura (música)

La intensidad: es la cantidad de energía acústica que contiene un sonido. La intensidad viene determinada por la potencia, que a su vez está determinada por la amplitud y nos permite distinguir si el sonido es fuerte o débil.

Los sonidos que percibimos deben superar el umbral auditivo (0 dB) y no llegar al umbral de dolor (140 dB). Esta cualidad la medimos con el sonómetro y los resultados se expresan en decibelios (dB) en honor al científico e inventor Alexander Graham Bell.

En música se escriben así: ``piano pianissimo´´(ppp) mas suave que pianissimo, ``Pianissimo´´ (pp) Muy suave, ``Piano´´ (p) suave, ``Mezzo Piano´´ (mp) medio suave, ``Mezzo Forte´´ (mf) medio fuerte, ``Forte´´ (f) fuerte, ``Fortissimo´´ (ff) Muy fuerte, ``forte fortissimo´(fff) mas fuerte que fortissimo.

El timbre: es la cualidad que confiere al sonido los armónicos que acompañan a la frecuencia fundamental.

Esta cualidad es la que permite distinguir dos sonidos, por ejemplo, entre la misma nota (tono) con igual intensidad producida por dos instrumentos musicales distintos. Se define como la calidad del sonido. cada cuerpo sonoro vibra de una forma distinta. Las diferencias se dan no solamente por la naturaleza del cuerpo sonoro (madera, metal, piel tensada, etc), sino también por la manera de hacerlo sonar (golpear, frotar, rascar). Una misma nota suena distinta si la toca una flauta, un violín, una trompeta… cada instrumento tiene un timbre que lo identifica o lo diferencia de los demás. Con la voz sucede lo mismo. El sonido dado por un hombre, una mujer, un/a niño/a tienen distinto timbre. El timbre nos permitirá distinguir si la voz es áspera,dulce, ronca o aterciopelada. También influye en la variación del timbre la calidad del material que se utilice. Así pues, el sonido será claro, sordo, agradable o molesto.

La duración: es la cualidad que determina el tiempo de vibración de un objeto. Por ejemplo, podemos escuchar sonidos largos, cortos, muy cortos, etc. Es el tiempo durante el cual se mantiene un sonido, está determinada por la longitud, que indica el tamaño de una onda, que es la distancia entre el principio y el final de una onda completa (ciclo); según esto podemos decir que por duración los sonidos pueden ser largos o cortos.

CUALIDAD

CARACTERÍSTICA

RANGO

Altura

Frecuencia de onda

Agudo, medio, grave

Duración

Longitud de onda o tiempo de vibración

Largo o corto

Intensidad

Amplitud de onda

Fuerte, débil o suave

Timbre

Armónicos de onda o forma de la onda

Fuente emisora del sonido

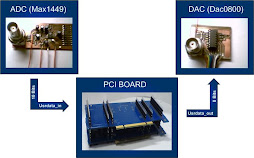

CONVERCION, A/D-D/A

CONVERSIÓN AD – DA

El procesado digital de las señales ofrece varias ventajas destacables frente al analógico. Entre dichas

ventajas cabe destacar la facilidad de implementación de sistemas digitales frente a sistemas analógicos,

pensemos por ejemplo en las diferencias de implementación entre un amplificador analógico y uno digital.

Por otro lado, los sistemas digitales son mucho más inmunes a los problemas físicos de los componentes

como son las derivas térmicas y las tolerancias de los componentes discretos. Los sistemas digitales son más

fácilmente adaptables a nuevas necesidades, es decir, en los mismos se pueden cambiar las especificaciones

sin necesidad de cambiar el propio sistema, pensemos por ejemplo en un filtro digital. Otra característica

destacable de los sistemas digitales es que en los mismos los datos se pueden almacenar con mayor facilidad

(memorias) y precisión siendo así mismo más fácil su recuperación.

La tendencia al uso de sistemas digitales también es evidente en el área de la instrumentación electrónica

pero el hecho de que la mayoría de las variables que pretendemos medir sean analógicas hace necesario su

transformación a un formato digital que pueda ser usado por el sistema digital en sí. En realidad, lo que

necesitamos es un interfaz capaz de asignar un código digital a cada valor de la variable analógica que

previamente se ha convertido en una señal eléctrica. A este interfaz es lo que denominamos convertidor

analógico digital (CAD). Cuando un dato en el sistema digital necesita ser usado como una señal analógica

usamos otro interfaz similar que denominamos convertidor digital analógico (CDA).

Muestreo

El muestreo es el proceso por el cual se obtienen una serie de muestras a partir de una señal analógica. El

tiempo de adquisición entre muestras se denomina periodo de muestreo y su inversa es la frecuencia de

muestreo. En la mayor parte de las aplicaciones el tiempo de muestro es constante.

Una serie de muestras discretas puede crear ambigüedad a la hora de determinar la señal analógica que

produjo dicha serie. Para ilustrar esta afirmación, puede observarse la Ilustración 1 en la que la serie discreta

de muestras podría haber sido obtenida de cualquiera de las señales analógicas mostradas. Este ejemplo pone

de manifiesto el hecho evidente de que en el proceso de muestreo se pierde información.

En relación al muestreo existe un importante teorema expuesto por Nyquist. Conocido como “Teorema de

muestreo de Nyquist” y se puede enunciar como: “Si la frecuencia más alta de una señal ( ) a x t es

Fmax = B y la señal se muestrea a una velocidad max 2 2 s F> F = B entonces ( ) a x t se puede recuperar

totalmente a partir de sus muestras mediante cierta función de interpolación”.

La interpretación práctica del teorema de muestreo es que es necesario muestrear a una velocidad

determinada relacionada con el ancho de banda de la señal para poder reconstruir sin ambigüedades la señal

original, es decir, para que la pérdida de información producida por el muestreo no sea significativa.

En la práctica, la frecuencia de Nyquist no es suficiente para obtener resultados satisfactorios en muchos

casos por lo que es recomendable muestrear al menos a 5 veces la mayor frecuencia de la señal analógica para evitar problemas

Cuantificación

Cuantificar una señal eléctrica continua consiste en representar sus valores en forma de una serie finita de N niveles de

tensión, corrientes o estados diferentes. El sistema que realiza esta función recibe el nombre de cuantificador.

Ilustración 2. Función de transferencia de un cuantificador uniforme y su error de cuantificación

La Ilustración 2 muestra la característica transferencial estática ideal de un cuantificador de N niveles ó estados , el error de

cuantificación y su densidad de probabilidad.

El margen de variación de la señal de entrada h para el cual la salida no cambia de valor o de estado se denomina intervalo de

cuantificación y es equivalente a la resolución del cuantificador. Para un cuantificador en el que el número de niveles o

estados a la salida sea N, la resolución se expresa como:

1 1

1

RESOLUCION

N N

= »

-

Aunque como habitualmente ocurre que N es lo suficientemente grande, la resolución se puede aproximar por la inversa del

propio número de estados como se indica en la expresión anterior.

Si la resolución es la misma para todo el margen estático de entrada del cuantificador de fondo de escala FS se trata entonces

de un cuantificador uniforme para el cual el intervalo de cuantificación viene dado Inherente a la función del cuantificador existe un error de cuantificación cuya amplitud o valor máximo se corresponde con la

mitad del valor del intervalo de cuantificación (h/2). En la cuantificación uniforme este error varia con la señal de entrada en

forma de un diente de sierra de periodo h por lo que, si N es grande y la señal de entrada se encuentra dentro del margen de

medida del cuantificador, la función densidad de probabilidad p(e) tiene forma rectangular de amplitud 1/h en todo el intervalo

[–h/2, h/2] como puede verse en la Ilustración 2.

Si expresamos N como una potencia de 2, es decir, N = 2n (donde n es el número de bits del código binario directo con el que

se representa a N), podemos conocer la resolución del cuantificador uniforme en función de dicho número de bits así como el

intervalo de cuantificación mediante las expresiones:

1

2n 2n

RESOLUCION = h = FS

Cuando la salida ‘y’ es expresada en términos de estados y estos son representados por N códigos digitales diferentes la

diferencia entre los códigos correspondientes a dos estados adyacentes es la unidad. Esta diferencia, expresada en términos de

la señal de entrada x, que generalmente es una tensión, se denomina peso del LSB (Least Significant Bit) y es equivalente a h.

En la Tabla 1 se presenta el valor de la resolución aproximada en función del número de estados. Obsérvese que a medida que

crece n la resolución es m

Codificación

Una vez que se tienen los distintos niveles de tensión ó corriente ó estados mediante el cuantificador tenemos que codificar

cada uno de esos niveles para representarlos unívocamente con los mismos. La codificación dependerá de la aplicación a

desarrollar así como del hardware disponible.

La generalidad de los procesadores digitales interpretan códigos binarios en los que las cifras usadas son solo dos, el 0 y el 1

(Bit de Binary Digit). Los códigos binarios que se usan para representar los estados correspondientes a señales unipolares se

denominan códigos binarios unipolares y los que representan señales bipolares códigos binarios bipolares.

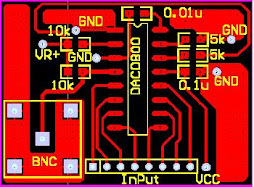

Conversión DA

La conversión digital-analógica es un procedimiento mediante el cual un código de entrada es transformado en una señal

(habitualmente de tensión) unipolar o bipolar de salida mediante una correspondencia entre 2n combinaciones binarias

posibles de entrada y 2n valores de la señal discretas de salida obtenidas a partir de una señal de referencia.

Característica estática del CDA

parámetros que caracterizan estáticamente un CDA son:

· Resolución: Dos códigos de entrada adyacentes se diferencian en 1 LSB, siendo esta la resolución que puede

expresarse en términos del peso porcentual respecto al fondo de escala como:

[%] 1 100 1 100

2n 1 2n RESOLUCION = »

-

· Ganancia: La ganancia de un CDA o sensibilidad es la pendiente de su característica transferencial estática. Es la

constante que relaciona el valor de la tensón de salida correspondiente al código de plena escala con la magnitud de la

referencia de tensión utilizada en el circuito. En la mayoría de las aplicaciones esta ganancia se ajusta a la unidad.

· Exactitud: La exactitud de un CDA es la diferencia entre el valor que se obtiene a la salida para un determinado

código a la entrada y el valor esperado teóricamente. Se expresa en términos de LSB.

Característica dinámica del CDA

La Ilustración 4 muestra la salida de un CDA de tensión Vo al producirse un cambio del código digital a su entrada. Un CDA

ideal ofrecería un cambio inmediato a su salida, mientras que en uno real este cambio se produce mediante un transitorio hasta

alcanzar el valor de salida correspondiente al código digital de entrada final.

La respuesta dinámica de los CDA se caracteriza por:

· Tiempo de establecimiento (Settling Time): Es la duración del transitorio desde que se produce el cambio del

código digital de entrada hasta que se alcanza en la salida el valor correspondiente a dicho código (valor aproximado

al mismo o comprendido en una banda expresada habitualmente en términos del LSB).

· Rapidez de cambio a la salida (Slew Rate): Es el cociente entre la tensión de salida a plena escala y el tiempo

requerido para alcanzar el valor correspondiente a plena escala partiendo del valor de cero. Se expresa en V/s.

· Frecuencia de conversión máxima: Es la frecuencia máxima a la que puede cambiar el código digital de entrada

obteniendo de manera correcta la salida corres

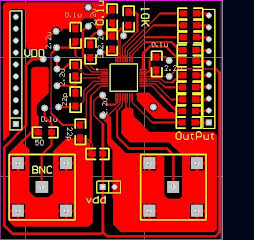

Conversión AD

La conversión analógica-digital es un procedimiento mediante el cual una señal analógica (habitualmente de tensión) unipolar

o bipolar es transformada en un código digital N a partir de la magnitud de la señal analógica de entrada y la de una referencia.

La conversión analógica- digital consiste en un muestreo, una cuantificación y una codificación.

7.1 Característica estática del CAD

Práctica 5. Conversión AD - DA

Instrumentación Electrónica 6 de 10

La Ilustración 6 muestra la característica de transferencia estática de un CAD, el error de cuantificación cometido y un

esquema del mismo. La característica estática recuerda a la de un cuantificador precisamente porque esta es la función

principal del CAD.

¥

Ilustración 6. a) Característica estática de un CAD; b) Error de cuantificación del CAD; c) Esquema de un CAD

La línea continua representa la función de transferencia ideal correspondiente a un CAD de infinito número de bits, mientras

que la escalonada representa la de un CAD de 3 bits que ofrece 8 códigos digitales a la salida. La entrada, en ambos casos se

representa normalizada respecto del valor de tensión máximo que en los CAD suele coincidir con Vref.

Los parámetros fundamentales que caracterizan estáticamente un CAD son los siguientes:

· Resolución: Variación necesaria en la tensión de entrada para provocar un cambio entre códigos adyacentes en el

código de salida. Para un convertidor uniforme, si N es el número total de códigos de la salida y FS el fondo de

escala, la resolución se cuantifica por:

1

RESOLUCION FS FS

N N

= »

-

· Margen de entrada: Se refiere al conjunto de valores de la entrada para los que el convertidor ofrece sus códigos de

salida. Por ejemplo 0V – 10V (unipolar); (-5V) – (+5V) (bipolar).

· Ganancia: Es la pendiente de la recta que une los puntos medios de los peldaños primero y último de la característica

transferencial estática del CAD. En el CAD ideal es la unidad.

· Exactitud absoluta: Es la diferencia entre el código que se obtiene a la salida para una determinada tensión de

entrada y el código esperado teóricamente. Se expresa en LSB o en tanto por ciento del valor a plena escala.

7.2 Característica dinámica del CAD

Un CAD no ofrece de forma inmediata el código a la salida correspondiente a la tensión de entrada. El proceso de muestreo

requiere de un determinado tiempo mientras que el de cuantificación codificación otro. Este tiempo depende de las

características propias del convertidor así como de la tecnología usada en cada una de sus partes.

Los parámetros fundamentales que caracterizan dinámicamente un CAD son los siguientes:

· Tiempo de conversión (Conversion Time): Es el tiempo necesario para que el convertidor realice una conversión, es

decir, el tiempo que transcurre desde que se empieza el muestreo de la señal de entrada y aparece el código digital

correspondiente a la salida.

· Frecuencia de conversión: Es la máxima frecuencia a la que el CAD puede ofrecer códigos estables a su salida en

modo de funcionamiento continuo.

Prácticapondiente.

El procesado digital de las señales ofrece varias ventajas destacables frente al analógico. Entre dichas

ventajas cabe destacar la facilidad de implementación de sistemas digitales frente a sistemas analógicos,

pensemos por ejemplo en las diferencias de implementación entre un amplificador analógico y uno digital.

Por otro lado, los sistemas digitales son mucho más inmunes a los problemas físicos de los componentes

como son las derivas térmicas y las tolerancias de los componentes discretos. Los sistemas digitales son más

fácilmente adaptables a nuevas necesidades, es decir, en los mismos se pueden cambiar las especificaciones

sin necesidad de cambiar el propio sistema, pensemos por ejemplo en un filtro digital. Otra característica

destacable de los sistemas digitales es que en los mismos los datos se pueden almacenar con mayor facilidad

(memorias) y precisión siendo así mismo más fácil su recuperación.

La tendencia al uso de sistemas digitales también es evidente en el área de la instrumentación electrónica

pero el hecho de que la mayoría de las variables que pretendemos medir sean analógicas hace necesario su

transformación a un formato digital que pueda ser usado por el sistema digital en sí. En realidad, lo que

necesitamos es un interfaz capaz de asignar un código digital a cada valor de la variable analógica que

previamente se ha convertido en una señal eléctrica. A este interfaz es lo que denominamos convertidor

analógico digital (CAD). Cuando un dato en el sistema digital necesita ser usado como una señal analógica

usamos otro interfaz similar que denominamos convertidor digital analógico (CDA).

Muestreo

El muestreo es el proceso por el cual se obtienen una serie de muestras a partir de una señal analógica. El

tiempo de adquisición entre muestras se denomina periodo de muestreo y su inversa es la frecuencia de

muestreo. En la mayor parte de las aplicaciones el tiempo de muestro es constante.

Una serie de muestras discretas puede crear ambigüedad a la hora de determinar la señal analógica que

produjo dicha serie. Para ilustrar esta afirmación, puede observarse la Ilustración 1 en la que la serie discreta

de muestras podría haber sido obtenida de cualquiera de las señales analógicas mostradas. Este ejemplo pone

de manifiesto el hecho evidente de que en el proceso de muestreo se pierde información.

En relación al muestreo existe un importante teorema expuesto por Nyquist. Conocido como “Teorema de

muestreo de Nyquist” y se puede enunciar como: “Si la frecuencia más alta de una señal ( ) a x t es

Fmax = B y la señal se muestrea a una velocidad max 2 2 s F> F = B entonces ( ) a x t se puede recuperar

totalmente a partir de sus muestras mediante cierta función de interpolación”.

La interpretación práctica del teorema de muestreo es que es necesario muestrear a una velocidad

determinada relacionada con el ancho de banda de la señal para poder reconstruir sin ambigüedades la señal

original, es decir, para que la pérdida de información producida por el muestreo no sea significativa.

En la práctica, la frecuencia de Nyquist no es suficiente para obtener resultados satisfactorios en muchos

casos por lo que es recomendable muestrear al menos a 5 veces la mayor frecuencia de la señal analógica para evitar problemas

Cuantificación

Cuantificar una señal eléctrica continua consiste en representar sus valores en forma de una serie finita de N niveles de

tensión, corrientes o estados diferentes. El sistema que realiza esta función recibe el nombre de cuantificador.

Ilustración 2. Función de transferencia de un cuantificador uniforme y su error de cuantificación

La Ilustración 2 muestra la característica transferencial estática ideal de un cuantificador de N niveles ó estados , el error de

cuantificación y su densidad de probabilidad.

El margen de variación de la señal de entrada h para el cual la salida no cambia de valor o de estado se denomina intervalo de

cuantificación y es equivalente a la resolución del cuantificador. Para un cuantificador en el que el número de niveles o

estados a la salida sea N, la resolución se expresa como:

1 1

1

RESOLUCION

N N

= »

-

Aunque como habitualmente ocurre que N es lo suficientemente grande, la resolución se puede aproximar por la inversa del

propio número de estados como se indica en la expresión anterior.

Si la resolución es la misma para todo el margen estático de entrada del cuantificador de fondo de escala FS se trata entonces

de un cuantificador uniforme para el cual el intervalo de cuantificación viene dado Inherente a la función del cuantificador existe un error de cuantificación cuya amplitud o valor máximo se corresponde con la

mitad del valor del intervalo de cuantificación (h/2). En la cuantificación uniforme este error varia con la señal de entrada en

forma de un diente de sierra de periodo h por lo que, si N es grande y la señal de entrada se encuentra dentro del margen de

medida del cuantificador, la función densidad de probabilidad p(e) tiene forma rectangular de amplitud 1/h en todo el intervalo

[–h/2, h/2] como puede verse en la Ilustración 2.

Si expresamos N como una potencia de 2, es decir, N = 2n (donde n es el número de bits del código binario directo con el que

se representa a N), podemos conocer la resolución del cuantificador uniforme en función de dicho número de bits así como el

intervalo de cuantificación mediante las expresiones:

1

2n 2n

RESOLUCION = h = FS

Cuando la salida ‘y’ es expresada en términos de estados y estos son representados por N códigos digitales diferentes la

diferencia entre los códigos correspondientes a dos estados adyacentes es la unidad. Esta diferencia, expresada en términos de

la señal de entrada x, que generalmente es una tensión, se denomina peso del LSB (Least Significant Bit) y es equivalente a h.

En la Tabla 1 se presenta el valor de la resolución aproximada en función del número de estados. Obsérvese que a medida que

crece n la resolución es m

Codificación

Una vez que se tienen los distintos niveles de tensión ó corriente ó estados mediante el cuantificador tenemos que codificar

cada uno de esos niveles para representarlos unívocamente con los mismos. La codificación dependerá de la aplicación a

desarrollar así como del hardware disponible.

La generalidad de los procesadores digitales interpretan códigos binarios en los que las cifras usadas son solo dos, el 0 y el 1

(Bit de Binary Digit). Los códigos binarios que se usan para representar los estados correspondientes a señales unipolares se

denominan códigos binarios unipolares y los que representan señales bipolares códigos binarios bipolares.

Conversión DA

La conversión digital-analógica es un procedimiento mediante el cual un código de entrada es transformado en una señal

(habitualmente de tensión) unipolar o bipolar de salida mediante una correspondencia entre 2n combinaciones binarias

posibles de entrada y 2n valores de la señal discretas de salida obtenidas a partir de una señal de referencia.

Característica estática del CDA

parámetros que caracterizan estáticamente un CDA son:

· Resolución: Dos códigos de entrada adyacentes se diferencian en 1 LSB, siendo esta la resolución que puede

expresarse en términos del peso porcentual respecto al fondo de escala como:

[%] 1 100 1 100

2n 1 2n RESOLUCION = »

-

· Ganancia: La ganancia de un CDA o sensibilidad es la pendiente de su característica transferencial estática. Es la

constante que relaciona el valor de la tensón de salida correspondiente al código de plena escala con la magnitud de la

referencia de tensión utilizada en el circuito. En la mayoría de las aplicaciones esta ganancia se ajusta a la unidad.

· Exactitud: La exactitud de un CDA es la diferencia entre el valor que se obtiene a la salida para un determinado

código a la entrada y el valor esperado teóricamente. Se expresa en términos de LSB.

Característica dinámica del CDA

La Ilustración 4 muestra la salida de un CDA de tensión Vo al producirse un cambio del código digital a su entrada. Un CDA

ideal ofrecería un cambio inmediato a su salida, mientras que en uno real este cambio se produce mediante un transitorio hasta

alcanzar el valor de salida correspondiente al código digital de entrada final.

La respuesta dinámica de los CDA se caracteriza por:

· Tiempo de establecimiento (Settling Time): Es la duración del transitorio desde que se produce el cambio del

código digital de entrada hasta que se alcanza en la salida el valor correspondiente a dicho código (valor aproximado

al mismo o comprendido en una banda expresada habitualmente en términos del LSB).

· Rapidez de cambio a la salida (Slew Rate): Es el cociente entre la tensión de salida a plena escala y el tiempo

requerido para alcanzar el valor correspondiente a plena escala partiendo del valor de cero. Se expresa en V/s.

· Frecuencia de conversión máxima: Es la frecuencia máxima a la que puede cambiar el código digital de entrada

obteniendo de manera correcta la salida corres

Conversión AD

La conversión analógica-digital es un procedimiento mediante el cual una señal analógica (habitualmente de tensión) unipolar

o bipolar es transformada en un código digital N a partir de la magnitud de la señal analógica de entrada y la de una referencia.

La conversión analógica- digital consiste en un muestreo, una cuantificación y una codificación.

7.1 Característica estática del CAD

Práctica 5. Conversión AD - DA

Instrumentación Electrónica 6 de 10

La Ilustración 6 muestra la característica de transferencia estática de un CAD, el error de cuantificación cometido y un

esquema del mismo. La característica estática recuerda a la de un cuantificador precisamente porque esta es la función

principal del CAD.

¥

Ilustración 6. a) Característica estática de un CAD; b) Error de cuantificación del CAD; c) Esquema de un CAD

La línea continua representa la función de transferencia ideal correspondiente a un CAD de infinito número de bits, mientras

que la escalonada representa la de un CAD de 3 bits que ofrece 8 códigos digitales a la salida. La entrada, en ambos casos se

representa normalizada respecto del valor de tensión máximo que en los CAD suele coincidir con Vref.

Los parámetros fundamentales que caracterizan estáticamente un CAD son los siguientes:

· Resolución: Variación necesaria en la tensión de entrada para provocar un cambio entre códigos adyacentes en el

código de salida. Para un convertidor uniforme, si N es el número total de códigos de la salida y FS el fondo de

escala, la resolución se cuantifica por:

1

RESOLUCION FS FS

N N

= »

-

· Margen de entrada: Se refiere al conjunto de valores de la entrada para los que el convertidor ofrece sus códigos de

salida. Por ejemplo 0V – 10V (unipolar); (-5V) – (+5V) (bipolar).

· Ganancia: Es la pendiente de la recta que une los puntos medios de los peldaños primero y último de la característica

transferencial estática del CAD. En el CAD ideal es la unidad.

· Exactitud absoluta: Es la diferencia entre el código que se obtiene a la salida para una determinada tensión de

entrada y el código esperado teóricamente. Se expresa en LSB o en tanto por ciento del valor a plena escala.

7.2 Característica dinámica del CAD

Un CAD no ofrece de forma inmediata el código a la salida correspondiente a la tensión de entrada. El proceso de muestreo

requiere de un determinado tiempo mientras que el de cuantificación codificación otro. Este tiempo depende de las

características propias del convertidor así como de la tecnología usada en cada una de sus partes.

Los parámetros fundamentales que caracterizan dinámicamente un CAD son los siguientes:

· Tiempo de conversión (Conversion Time): Es el tiempo necesario para que el convertidor realice una conversión, es

decir, el tiempo que transcurre desde que se empieza el muestreo de la señal de entrada y aparece el código digital

correspondiente a la salida.

· Frecuencia de conversión: Es la máxima frecuencia a la que el CAD puede ofrecer códigos estables a su salida en

modo de funcionamiento continuo.

Prácticapondiente.

CODECS FLAG,MP3,APL.

Free Lossless Audio Codec (FLAC)

(Códec libre de compresión de audio sin pérdida, en español) es un formato del proyecto Ogg para codificar audio sin pérdida de calidad, es decir, el archivo inicial puede ser recompuesto totalmente con la desventaja de que el archivo ocupe mucho más espacio del que se obtendría al aplicar compresión con pérdida o Lossy.

Otros formatos como MPEG-1 Layer 3 (MP3), Windows Media Audio (WMA) (excepto WMA Lossless), Advanced Audio Coding (AAC), Ogg Vorbis (OGG), Adaptive Transform Acoustic Coding ATRAC, ADPCM, etc., al comprimir el archivo pierden, de forma irreversible, parte de la información del original, a cambio de un gran ahorro de tamaño en el archivo. FLAC no ahorra tanto tamaño de archivo, rara vez baja de dejar el archivo en un tercio del tamaño original, ya que no elimina nada de la información contenida en el original. Como norma se reduce entre la mitad hasta tres cuartos según el tipo de sonido procesado.

Comparaciones

FLAC está diseñado para comprimir audio. Debido a ello, los archivos resultantes son reproducibles y útiles, además de ser más pequeños que si se hubiera aplicado directamente al archivo PCM un algoritmo de compresión estadística (como ZIP). Los algoritmos con pérdida pueden comprimir a más de 1/10 del tamaño inicial, a costa de descartar información; FLAC, en su lugar, usa la predicción lineal para convertir las muestras en series de pequeños números no correlativos (conocido como "residuos"), que se almacenan eficientemente usando la codificación Golomb-Rice (ver: "Reglas Golombinas", o "Golombianas"). Además de esto, para aprovechar los silencios (donde los valores numéricos presentan mucha repetición) usa codificación por "longitud de pista" (RLE"Run-Length Encoding") para muestras idénticas.

Nota: RLE y RAE son conceptos provenientes de la lectura mecánica de los registros, y se corresponden a las lecturas con "Velocidad Lineal Constante" (típicas de las cintas magnetofónicas), y con "Velocidad Angular Constante" (característica de los discos y gramófonos. En los lectores de CD, se puede seleccionar un método u otro de reproducción, según los parámetros de grabación. El más común es CAV, pero el CLV permite una mayor linealidad en el registro; aunque requiere el concurso de servos para controlar la velocidad angular del rotor, según se acorta el radio de la pista.

FLAC se ha convertido en uno de los formatos preferidos para la venta de música por Internet, al igual que Monkey's Audio que funciona idénticamente bien. Además es usado en el intercambio de canciones por la red, como alternativa al MP3, cuando se desea obtener una mayor reducción del tamaño que en un archivo WAV-PCM, y no perder calidad de sonido. También es el formato ideal para realizar copias de seguridad de CDs, ya que permite reproducir exactamente la información del original, y recuperarla en caso de problemas con este material.

FLAC no soporta muestras en coma flotante, sólo en coma fija. Admite cualquier resolución PCM de 4 a 32 bits, y cualquier frecuencia de muestreo (sample rate) desde 1 a 65535KHz, en incrementos de 1Hz.

Para una mayor compresión consiguiendo un mayor tiempo de codificación se puede usar el siguiente comando

flac --lax -mep -b 8192 -l 32 -r 0,16 input.wav -o output.flac

El fichero resultante puede no funcionar en reproductores normales, pero funcionara en los decodificadores software. Para evitar esto debe usar el siguiente comando:

flac --lax -mep -b 8192 -l 32 -r 0,8 input.wav -o output.flac

Tabla comparativa de funcionalidades

Habitualmente uno de los factores que más se tienen en cuenta a la hora de escoger este códec de audio es la compresión que aporta; sin embargo, dependiendo de cuál sea nuestra aplicación final y de si se consideran los medios de los que dispose el usuario, no siempre nos conviene ni el códec más rápido ni el que más comprima. En esta tabla queda demostrado que el FLAC es una buena opción en muchos de los distintos casos en los que un usuario se puede encontrar; aquí se comparan las funcionalidades más destacadas de éste con las de otros códecs de audio sin pérdidas. Los códecs analizados son los siguientes:

WavPack

Apple Lossless (ALAC)

FLAC

Monkey's

OptimFROG

Shorten

Características de los archivos

Los archivos FLAC suelen tener esta misma extensión (*.FLAC); son perfectamente reproducibles con algunos reproductores, incluso en computadoras antiguas, ya que una de las características del proyecto, es que los archivos decodifiquen en modo sencillo. Además permiten usar la función búsqueda. Estos archivos son de velocidad de bits variable, ya que no todas las partes de una misma canción son igualmente comprimibles.

Otra característica es que, como todos los formatos sin pérdida, el ratio final depende mucho del estilo musical, y de su complejidad y variedad sonora, aparte de la propia canción. Para música clásica obtiene ratios de aproximadamente 1/2; en otros estilos, como el dance o el rock, los archivos se quedan desde 2/3 hasta 4/5 del tamaño original en formato PCM. Otro factor de mucha importancia es la existencia de los silencios, ya que algunas canciones tienen varios segundos al principio o al final.

MP3

.

MPEG-1 Audio Layer 3 (MP3)

Información general

Extensión de archivo

.mp3

Tipo de MIME

audio/mpeg

Tipo de formato

Audio

Estándar(es)

ISO/IEC 11172-3, ISO/IEC 13818-3

MPEG-1 Audio Layer 3, más conocido como MP3, es un formato de audio digital comprimido con pérdida desarrollado por el Moving Picture Experts Group (MPEG) para formar parte de la versión 1 (y posteriormente ampliado en la versión 2) del formato de vídeo MPEG. El mp3 estándar es de 44 kHz y un bitrate de 128 kbps por la relación de calidad/tamaño. Su nombre es el acrónimo de MPEG-1 Audio Layer 3 y el término no se debe confundir con el de reproductor MP3. Codificación y cuantificación

La solución que propone este estándar en cuanto a la repartición de bits o ruido, se hace en un ciclo de iteración que consiste de un ciclo interno y uno externo. Examina tanto las muestras de salida del banco de filtros como el SMR (signal-to-mask ratio) proporcionado por el modelo psicoacústico, y ajusta la asignación de bits o ruido, según el esquema utilizado, para satisfacer simultáneamente los requisitos de tasa de bits y de enmascaramiento. Dichos ciclos consisten en:

Ciclo interno